Verso una nuova immersione: come la realtà mista ridefinisce il volo

L’ecosistema della simulazione di volo è in fermento. Con il rilascio e l’evoluzione costante di titoli come Microsoft Flight Simulator, l’attenzione si sposta sempre più verso tecnologie che possono migliorare immersione, interazione e realismo. Tra queste, la realtà mista e i sistemi di tracking mano/occhi rappresentano probabilmente i cambiamenti più profondi nei prossimi anni. In questo articolo analizziamo le prospettive per FS2024 integrando aspetti tecnici, UX, requisiti hardware, implicazioni per sviluppatori e opportunità per la community.

Che cos’è la realtà mista nel contesto della simulazione di volo

Il termine realtà mista (MR) indica la sovrapposizione e la fusione di elementi digitali con il mondo reale in modo coerente e interattivo. Nel contesto della simulazione di volo, la MR può spaziare da overlay HUD visivi inseriti nell’ambiente reale, a cockpit virtuali proiettati in uno spazio fisico, fino a scenari ibridi in cui parti del cockpit sono reali e parti virtuali. L’obiettivo è incrementare il senso di presenza e ridurre la distanza tra pilota virtuale e macchina.

Differenze tra VR, AR e MR applicate al volo

La realtà virtuale (VR) immerge completamente l’utente in un ambiente digitale; la realtà aumentata (AR) sovrappone elementi digitali al mondo reale; la realtà mista combina questi approcci con un’interazione contestuale più profonda. Per FS2024, la MR può permettere al pilota di vedere strumenti virtuali sovrapposti a componenti fisiche del proprio cockpit, oppure di integrare indicatori di volo direttamente sulle finestre reali di un abitacolo.

Tracking mano e tracking occhi: cosa sono e come funzionano

Il tracking mano/occhi comprende due famiglie di tecnologie: il tracciamento delle mani (hand tracking) e il tracciamento degli occhi (eye tracking). Entrambe offrono modalità molto naturali di interazione, cruciali per portare la simulazione di volo a un livello superiore.

Hand tracking

Il tracciamento delle mani utilizza sensori ottici o a infrarossi per riconoscere la posizione, l’orientamento e i gesti delle mani dell’utente. A livello pratico, questo permette di toccare, afferrare e manipolare elementi del cockpit virtuale senza necessità di controller fisici. In uno scenario MR per FS2024, l’utente potrebbe ruotare una manopola virtuale, spostare leve o premere interruttori semplicemente usando le proprie mani.

Eye tracking

Il tracciamento degli occhi rileva la direzione dello sguardo e la focalizzazione visiva. Questa informazione può essere usata per mirare automaticamente un cursore, per ottimizzare il rendering mediante foveated rendering o per aumentare il realismo della cabina, facendo sì che gli strumenti reagiscano quando il pilota li osserva. Nel volo simulato, lo eye tracking può migliorare la gestione dei sistemi avionici e ridurre i tempi di interazione.

Perché queste tecnologie sono importanti per FS2024

Combinate, realtà mista e tracking mano/occhi possono trasformare l’esperienza utente: più naturalezza nelle manovre, minore curva di apprendimento per nuovi piloti virtuali e maggiore immersione. Per FS2024, le possibilità sono molteplici:

Miglioramento dell’interfaccia utente

L’interazione basata sulle mani e sullo sguardo semplifica l’uso degli strumenti complessi del simulatore. Invece di navigare menu con mouse e tastiera, il pilota può guardare un pannello per metterlo in evidenza e usare le mani per operare. Questo approccio rende l’esperienza più vicina al volo reale.

Prestazioni e ottimizzazione

Lo eye tracking abilitando il foveated rendering consente di concentrare le risorse di calcolo dove l’utente guarda, riducendo il carico sulla GPU e migliorando le prestazioni su hardware consumer. Per FS2024, che già richiede risorse notevoli per mappare il mondo in tempo reale, questa ottimizzazione è strategica.

Accessibilità e formazione

Per utenti con limitazioni fisiche, il tracking delle mani e degli occhi può rappresentare una modalità alternativa di controllo. Dal punto di vista dell’addestramento, gli istruttori possono monitorare lo sguardo degli allievi per valutare attenzione e procedure, creando scenari di training più efficaci.

Implementazione tecnica: sfide e soluzioni

L’integrazione di MR e tracking in un simulatore complesso come FS2024 implica una serie di sfide tecniche che richiedono soluzioni precise e bilanciate.

Sincronizzazione tra mondo reale e mondo virtuale

La registrazione spaziale e la calibrazione sono fondamentali. In MR occorre che gli oggetti virtuali coincidano con quelli reali. Errori di allineamento provocano disorientamento e riducono il realismo. Sistemi di calibrazione automatici, basati su marker o SLAM (Simultaneous Localization and Mapping), sono indispensabili per mantenere coerenza tra rappresentazione visiva e posizione fisica del cockpit.

Latenza e feedback tattile

La latenza tra movimento della mano e risposta visiva deve essere estremamente bassa per garantire sensazioni naturali. Nei casi in cui non è possibile fornire feedback tattile reale, soluzioni come il feedback aptico localizzato su joystick o guanti aptici leggeri possono mitigare il problema.

Riconoscimento dei gesti contestuale

Non tutti i gesti devono essere interpretati come comandi. Occorre distinguere tra movimenti naturali e input intenzionali; ciò richiede modelli di riconoscimento avanzati e contestualizzazione basata sullo stato del simulatore (ad esempio, la modalità “interazione cockpit” vs “modalità navigazione”).

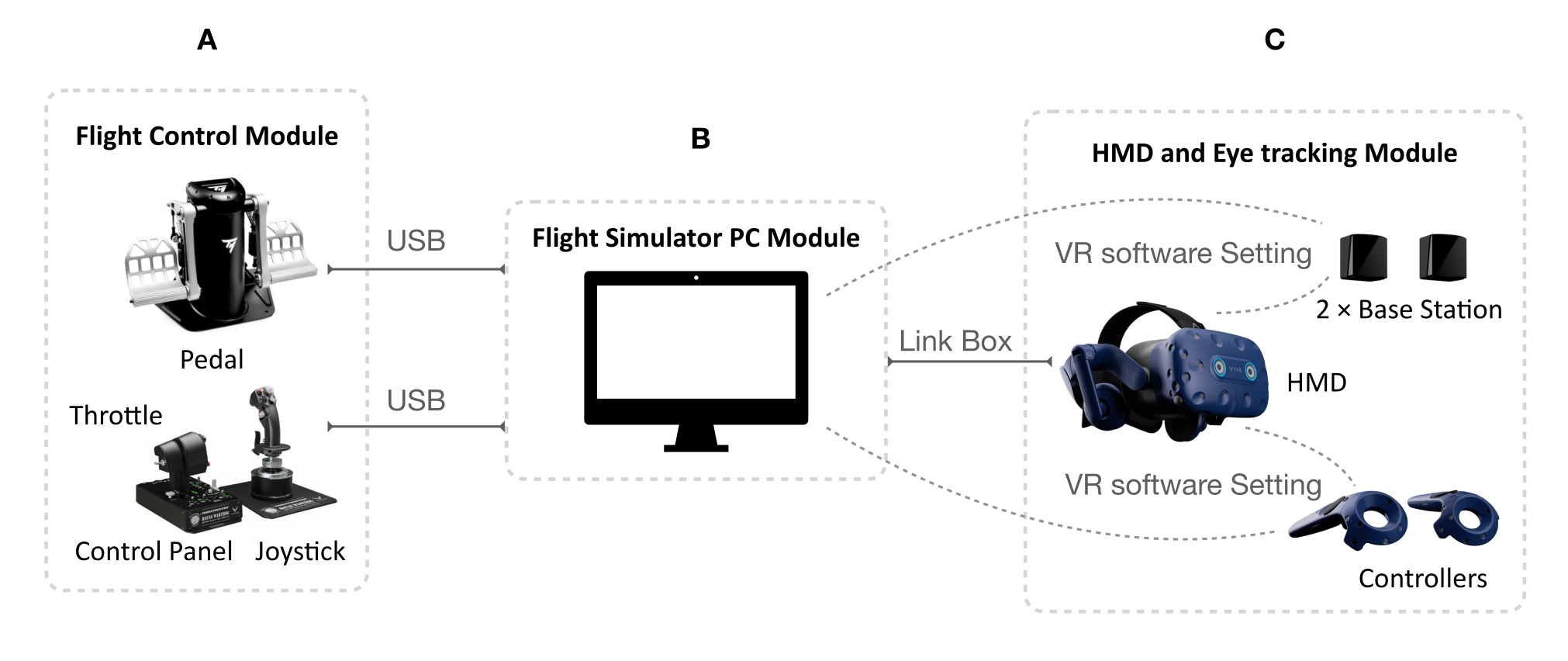

Requisiti hardware per un’esperienza soddisfacente

Per sfruttare pienamente realtà mista e tracking mano/occhi con FS2024 è necessario un parco hardware performante ma anche coerente con il budget degli utenti più appassionati.

Headset MR e sensori

Gli headset MR moderni integrano già sensori per il tracking e display con risoluzioni elevate; per FS2024 è consigliabile usare dispositivi con basso peso, buona ergonomia e risoluzione sufficiente a leggere cockpit dettagliati. Sistemi standalone con tracking inside-out permettono setup più semplici rispetto a soluzioni tethered.

Unità di calcolo

Una GPU di fascia alta e CPU veloci restano fondamentali, soprattutto se si pensa al rendering del mondo reale a elevata fedeltà. L’uso del eye tracking per foveated rendering può ridurre notevolmente il carico sulla GPU, ma non lo elimina del tutto, specialmente con scenari meteorologici complessi e modelli di terreno dettagliati.

Periferiche di interazione

Guanti aptici, controller 6DoF, sensori di posizione esterni (per soluzioni room-scale) e dispositivi di forza per i comandi di volo possono migliorare l’immersività. Tuttavia, per l’adozione di massa è importante che il sistema funzioni anche con periferiche minime, utilizzando il tracking delle mani come alternativa ai controller tradizionali.

Integrazione in FS2024: opportunità per sviluppatori e modder

Per gli sviluppatori e la community modding, l’apertura delle API e la possibilità di integrare plugin di terze parti saranno decisive per il successo delle tecnologie MR e del tracking.

API per tracking e input

FS2024 dovrebbe offrire API ben documentate per accedere ai dati di tracciamento occhi e mani, permettendo ai developer di creare esperienze personalizzate, come pannelli interattivi, sistemi di checklist basati sullo sguardo o HUD contestuali che reagiscono ai gesti.

Strumenti per la calibrazione e la UI adattiva

Toolkit per calibrare facilmente installazioni MR, template di UI ottimizzati per lo sguardo e librerie di riconoscimento gestuale velocizzeranno lo sviluppo. Creare guide in-app per calibrazione e training ridurrà il tasso di abbandono da parte degli utenti meno esperti.

Esempi pratici di mod e plugin

– Plugin che attivano l’indicazione degli strumenti guardati dall’utente, visualizzando informazioni aggiuntive in overlay.

– Mod per cockpit ibridi, dove strumenti fisici vengono mappati a componenti virtuali con logiche di sincronizzazione.

– Sistemi di assistenza al decollo/atterraggio che forniscono suggerimenti visuali basati sul tracciamento dello sguardo.

Esperienza utente: scenari d’uso concreti

Descriviamo alcuni scenari pratici per capire come la realtà mista e il tracking mano/occhi possono trasformare il gameplay e la formazione in FS2024.

Scenario 1 — Addestramento al cockpit

Un istruttore può far indossare all’allievo un headset MR che mostra strumenti virtuali supplementari. Il sistema registra lo sguardo dell’allievo per analizzare quali procedure sono state controllate e quali trascurate, fornendo report dettagliati post-sessione.

Scenario 2 — Volo ricreativo con overlay informativi

Durante un volo turistico, l’utente vede informazioni turistiche, indicatori di rotta e suggerimenti di navigazione sovrapposti al mondo reale. Il tracking delle mani permette di selezionare un punto di interesse per ottenere informazioni vocali o testuali senza interrompere il volo.

Scenario 3 — Cockpit ibrido casalingo

Un appassionato costruisce un mockup di cockpit parziale con leve reali; la MR completa con strumenti virtuali e pannelli supplementari. Il tracking delle mani consente interazioni naturali con entrambi gli elementi fisici e virtuali, creando un’esperienza molto convincente a costi contenuti.

Sicurezza, privacy e aspetti etici

L’introduzione di dati biometrici come lo sguardo richiede attenzione a privacy e sicurezza. Le informazioni sullo sguardo possono rivelare abitudini, attenzione e reazioni emotive. È quindi necessario stabilire policy chiare per la raccolta, l’elaborazione e lo storage di questi dati, con opzioni per disabilitarne la registrazione o anonimizzarli.

Consenso e trasparenza

Ogni applicazione che raccoglie dati di eye tracking o gesture tracking dovrebbe informare chiaramente l’utente su cosa viene raccolto, come viene usato e per quanto tempo viene conservato. Il consenso esplicito e le impostazioni granulari sono pratiche essenziali.

Protezione dei dati

I dati sensibili andrebbero cifrati e, ove possibile, elaborati in locale per limitare la trasmissione a server esterni. Soluzioni edge computing e processamento on-device possono mitigare i rischi legati alla privacy.

Prospettive future e roadmap plausibile per FS2024

Guardando avanti, possiamo ipotizzare una roadmap a breve e medio termine su come realtà mista tracking FS2024 potrebbe evolvere:

Breve termine (12-24 mesi)

– Supporto nativo per eye e hand tracking nelle API di FS2024.

– Possibilità di attivare funzionalità MR tramite plugin ufficiali.

– Iniziative community per creare cockpit ibridi e mod di integrazione.

Medio termine (2-5 anni)

– Standardizzazione di formati per la calibrazione MR tra vari dispositivi.

– Adozione diffusa del foveated rendering basato su eye tracking.

– Ecosistema di periferiche economiche (guanti, sensori di posizione) per l’utenza domestica.

Lungo termine (oltre 5 anni)

– Cockpit domestici sempre più realistici e accessibili.

– Integrazione di AI per riconoscere pattern di attenzione e suggerire miglioramenti di volo.

– Norme e certificazioni per l’uso dei dati biometrici nella formazione.

Consigli pratici per utenti e sviluppatori

Per sfruttare al meglio le potenzialità della realtà mista e del tracking mano/occhi, ecco alcune raccomandazioni concrete.

Per gli utenti

– Investire in un headset con buon comfort e sensori di tracking affidabili.

– Calibrare frequentemente sistemi eye e hand tracking per mantenere precisione.

– Testare configurazioni MR in sessioni brevi per adattarsi e ridurre la fatica visiva.

Per gli sviluppatori

– Esporre impostazioni di sensibilità e soglie per il riconoscimento gestuale.

– Fornire modalità fallback per utenti senza tracking o con hardware limitato.

– Offrire strumenti di logging e diagnostica per aiutare la community a risolvere problemi di calibrazione.

Check-list tecnica rapida

– Verificare latenza end-to-end del tracking.

– Implementare smoothing adattivo per ridurre jitter nelle mani.

– Utilizzare foveated rendering quando disponibile per alleggerire la GPU.

– Testare la UX con utenti reali e raccogliere metriche di attenzione e successo operativo.

Impatto sulla community e sul mercato

L’adozione di MR e tracking mano/occhi aprirà nuove nicchie di mercato: training professionale, appassionati con cockpit casalinghi, tour virtuali e persino usi cinematografici per registrazioni realistiche. La community di modding di FS2024 gioca qui un ruolo chiave: molte innovazioni nascono da sperimentazioni amatoriali che poi vengono adottate su larga scala.

Conclusione: opportunità e responsabilità

La convergenza tra realtà mista e tracking mano/occhi rappresenta una delle opportunità più promettenti per FS2024. Dal punto di vista tecnico e dell’esperienza utente, queste tecnologie offrono strumenti potenti per aumentare realismo, accessibilità e divertimento. Tuttavia, il successo dipenderà dalla qualità dell’implementazione, dall’attenzione alla privacy e dalla capacità della community e degli sviluppatori di collaborare per creare soluzioni robuste e inclusive.

Per chi è interessato a sperimentare, il consiglio è chiaro: iniziare con setup modulari, dare priorità alla calibrazione e testare progressivamente nuove interazioni. La strada verso una vera simulazione immersiva è percorribile, ma richiede attenzione tecnica, etica e collaborazione tra tutti gli attori coinvolti.

In sintesi, realtà mista tracking FS2024 non è solo una tendenza: è un cambiamento di paradigma che può ridefinire l’esperienza di volo virtuale nei prossimi anni.